목록전체 글 (154)

마짱짱의 지식창고

[K8S] NFS를 이용한 Storageclass 구성

[K8S] NFS를 이용한 Storageclass 구성

스크립트 합본#!/bin/bashnfs_server="192.168.252.49"nfs_dir_path="/app"kubectl create namespace nfs-provisionerhelm repo add nfs-subdir-external-provisioner https://kubernetes-sigs.github.io/nfs-subdir-external-provisioner/helm repo updatehelm install -n nfs-provisioner nfs-subdir-external-provisioner nfs-subdir-external-provisioner/nfs-subdir-external-provisioner \--set nfs.server=$nfs_server \--set n..

Rancher를 이용하여 k8s 환경구성

Rancher를 이용하여 k8s 환경구성

구성 Master Node 1대 Worker Node 1대 구성 소프트웨어 RKE2, Rancher 1. Master Node 구성하기 스왑메모리 중지합니다. swapoff -a 0으로 변경되었는지 확인합니다. free -h RKE2 설치 주의: Type이 Server 인지 확인합니다. curl -sfL https://get.rke2.io | INSTALL_RKE2_TYPE="server" sh - RKE2 실행 start 명령어 시 시간 걸립니다. systemctl enable rke2-server.service systemctl start rke2-server.service systemctl status rke2-server.service kubectl 명령어가 실행될 수 있도록 기본 디렉토리로 연결..

Client 환경: Ubuntu 22.02 k8s 환경: EKS 필요도구: awscli 1. Velero Client(Velero CLI) 설치하기 wget https://github.com/vmware-tanzu/velero/releases/download/v1.12.1/velero-v1.12.1-linux-amd64.tar.gz tar -xvf velero-v1.12.1-linux-amd64.tar.gz sudo mv velero-v1.12.1-linux-amd64/velero /usr/local/bin # 자동완성은 아래 링크 확인하여 본인 환경으로 세팅 https://velero.io/docs/v1.12/customize-installation/#optional-velero-cli-configur..

Prometheus-stack으로 Grafana까지 쉽게 설치하기

Prometheus-stack으로 Grafana까지 쉽게 설치하기

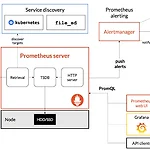

1. Helm 설치 curl -fsSL -o get_helm.sh https://raw.githubusercontent.com/helm/helm/main/scripts/get-helm-3 chmod 700 get_helm.sh ./get_helm.sh 2. Prometheus-stack (Grafana) 설치 helm repo add prometheus-community https://prometheus-community.github.io/helm-charts helm repo update helm install prometheus-stack prometheus-community/kube-prometheus-stack 2-1. 구성요소 1. Prometheus: Prometheus는 오픈 소스 모니터링 ..

[GCP] Jenkins 이용하여 GKE Canary 배포

[GCP] Jenkins 이용하여 GKE Canary 배포

0. 개요 해당 포스팅에서는 Kubernetes Engine에서 Jenkins를 사용하여 지속적 배포 파이프라인을 설정하는 방법을 배우게 됩니다. Jenkins는 공유 저장소에서 코드를 자주 통합하는 개발자가 즐겨 사용하는 자동화 서버입니다. 이 실습에서 빌드할 솔루션은 다음 다이어그램과 유사합니다. Jenkins 애플리케이션을 Kubernetes Engine 클러스터에 프로비저닝하기 Helm Package Manager를 사용하여 Jenkins 애플리케이션 설정하기 Jenkins 애플리케이션의 기능 살펴보기 Jenkins 파이프라인 생성 및 실습 Jenkins란 무엇인가요? Jenkins는 빌드, 테스트, 배포 파이프라인을 유연하게 조정할 수 있는 오픈소스 자동화 서버입니다. Jenkins를 사용하면 ..

[GCP] Jenkins로 GKE 연결하기

[GCP] Jenkins로 GKE 연결하기

0. 개요 해당 포스팅에서는 소프트웨어 제공 파이프라인을 조정하는 데 도움이 되도록 Google Kubernetes Engine에서 Jenkins를 설정하는 방법에 대해 알아봅니다. Kubernetes Engine으로 Kubernetes 클러스터 만들기 Jenkins 배포 및 서비스 만들기. 젠킨스에 연결 중입니다. 1. 환경준비 Cloud Shell 에서 Zone 설정 후 샘플코드 clone gcloud config set compute/zone us-central1-f git clone https://github.com/GoogleCloudPlatform/continuous-deployment-on-kubernetes.git cd continuous-deployment-on-kubernetes GKE..